欧盟《人工智能法案》解读

陈富成 蔡宗秀 | 2023-05-24

欧盟《人工智能法案》解读

陈富成 蔡宗秀 | 2023-05-24

引言

近年来,人工智能愈发凸显其对于经济与社会发展的强大驱动力与潜力。与此同时,人工智能的发展也带来了不可估量的风险。基于此,欧盟公布了一项新的提案——《人工智能法案》(Artificial Intelligence Act,2021/0106,以下简称为“法案”)。若顺利,《人工智能法案》预计将于2024年正式生效,并很可能成为自《通用数据保护条例》后欧盟又一具有广泛影响力的立法。在此背景下,笔者将对法案的要点进行解读,以期为相关出海企业提供参考。

一、《人工智能法案》沿革

2021年4月21日,欧盟委员会发布了法案,旨在通过制定统一的法律框架,确保基于人工智能的商品和服务能够在保护生命、健康等公民基本权利和保障公共利益的前提下自由跨境流通,改善市场对于人工智能的开发、使用和营销。

2022年12月6日,欧盟理事会就欧盟委员会起草的法案达成一致立场,受ChatGPT等应用快速发展的影响,法案增加了关于通用人工智能、基础模型等条款。

2023年4月27日,欧洲议会成员在委员会投票前,达成了相关修正的提案,包括基础模型开发商披露使用版权材料、基础模型遵守言论自由原则等内容。

2023年5月11日,欧洲议会的公民自由、司法和内政事务委员会(LIBE Committee)和国内市场和消费者保护委员会(IMCO Committee)以84票赞成、7票反对和12票弃权通过了关于法案的谈判授权草案。欧洲议会预计于2023年6月14日进行全体会议投票,投票通过后,法案将进入立法程序的最后阶段——欧洲议会、欧盟理事会、欧盟委员会的三方谈判(Trilogues)。

二、《人工智能法案》要点解读

1、人工智能的定义和适用范围

法案将人工智能系统(Artificial Intelligence system)定义为“基于机器的系统,旨在以不同程度的自主权运行,并且可以针对明确或隐含的目标生成例如预测、建议或决策等输出,影响物理或虚拟的环境。”

法案的适用范围也较为广泛,即便企业是欧盟范围外人工智能技术的供应商,但所使用其人工智能技术的产品或服务提供在欧盟范围内,也需要适用法案的相关规定。

具体而言,法案的适用范围为:

此外,法案并不适用于军事、国防和国家安全、第三国根据与欧盟执法和司法合作协议而使用的、用于科学研究的、自然人用于私人事务的人工智能,以及已经受特定法规约束的相关行业(例如民航、铁路、汽车等)对于人工智能的使用。

2、风险等级分类

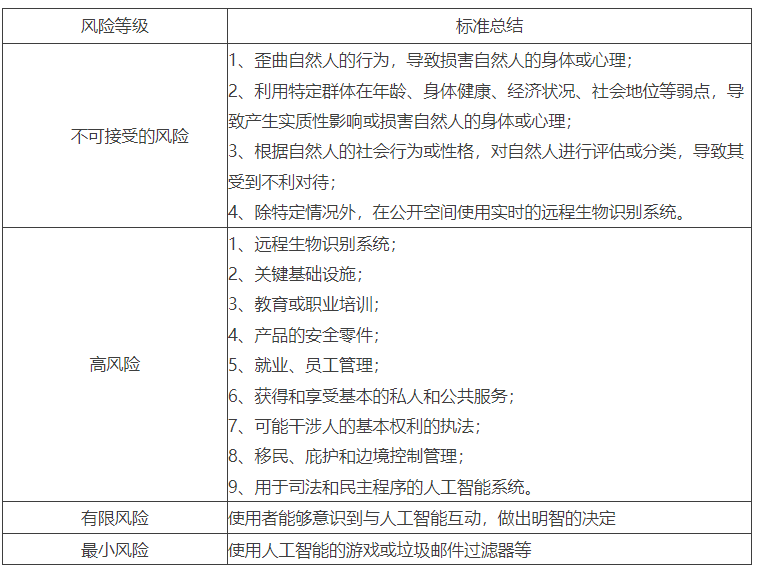

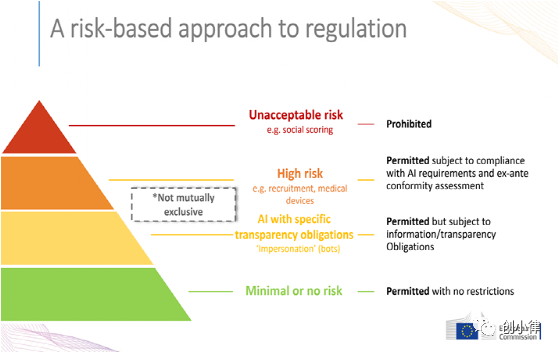

法案将人工智能系统根据风险评估分为了四类,包括不可接受的风险、高风险、有限风险与最小风险。四类风险等级的评估标准如下表:

对于不同风险等级,法案采取了不同程度的监管措施。对于不可接受风险的人工智能,法案严厉禁止,并对违反者处于上一财年全球营业额最高6%的处罚;对于高风险的人工智能,法案规定了一套完整的全流程风险管理措施(见下文);对于有限风险的人工智能,法案要求履行公开透明义务;而对于最小风险的人工智能,法案并不作干预。

图1:风险等级分类,European Commission

3、全流程风险管理措施

针对高风险的人工智能,法案规定了从人工智能入市前到入市后的全流程风险管理措施。具体而言:

1).入市前

建立和维持风险管理系统,风险管理系统需要能够识别已知的和可预见的以及使用后可能存在的风险;

进行数据治理,训练人工智能系统的数据应当满足一定的质量标准要求,并且在对于数据的训练、验证、测试等环节,需要遵循相应的管理规定;

在人工智能系统入市前,应当制定并更新技术文档,并向主管部门提供所有必要的信息;

人工智能系统应当在技术上设计为自动记录相关日志,并且能够进行追溯。日志至少应当包括记录时间、参考数据库、输入数据以及参与自然人等;

人工智能系统应当确保其操作足够透明,附有简明、完整、正确和清晰的信息,使得用户能够正确理解和使用系统;

人工智能系统的设计应当保证人能够实施干预。

2).入市时

人工智能系统应当进行合格评估,由相关机构验证人工智能系统是否满足前述入市前的各项管理要求;并起草一份合格声明,交由国家监督机构和主管部门保管;

人工智能系统在投放入市场或投入使用时,应当在欧盟建立的数据库中进行备案。该数据库可以为公众免费使用浏览,并可以被机器所读取;

人工智能系统在投放入市场时,应当贴上实体/数字形式的CE标志(欧洲共同市场安全标志,贴有CE标志的产品可以在欧盟成员国内自由流通)。

3).入市后

人工智能系统入市后,应当建立入市后检测系统,收集、记录和分析人工智能系统在整个生命周期的性能数据;

在人工智能系统发生严重事件时,人工智能系统的提供者应当在意识到该严重事件后72小时内向国家监督机构报告。

4、监管沙盒

法案要求欧盟成员国在法案生效前至少建立并投入使用一个人工智能监管沙盒。由主管机构提供受控的环境,对参与者对人工智能系统的测试与开发进行指导和监督,以确定相关风险。在特定条件下,人工智能监管沙盒允许开发和测试处理个人数据的人工智能系统。

5、生成式人工智能

法案将基础模型被定义为“使用在人工智能系统中以不同程度的自主权,专门用于生成复杂文字、图像、音频或视频等内容”。这种基础模型其实也就是ChatGPT等生成式人工智能所使用的模型。对此,法案要求生成式人工智能使用的基础模型的提供者应当根据欧盟法律规定的基本权利(如言论自由)进行设计和开发。同时,在使用版权法保护的数据进行训练时,需要进行公开披露。

三、对我国人工智能治理体系之启示

2023年4月11日,国家网信办发布了《生成式人工智能服务管理办法(征求意见稿)》(以下简称为“办法”)。办法承袭了《互联网信息服务算法推荐管理规定》与《互联网信息服务深度合成管理规定》的主旨,对生成式人工智能发展和规范应用提出了一系列要求。与法案相比,办法体现了不同的监管思路。然而,法案在风险等级分类、监管沙盒等方面还是存在一定借鉴意义。

《互联网信息服务算法推荐管理规定》中规定了对于算法推荐服务提供者的分级分类管理制度,但办法中并未对生成式人工智能产品或服务的提供者进行分级分类管理。人工智能的应用场景较为广泛,若对所有人工智能产品或服务适用统一的监管规则,部分提供者可能会承担过高的合规义务,不利于市场竞争。比如办法第四条规定:“提供生成式人工智能产品或服务应当遵守法律法规的要求,尊重社会公德、公序良俗,符合以下要求:……(四)利用生成式人工智能生成的内容应当真实准确,采取措施防止生成虚假信息。”对于将生成式人工智能用于游戏背景故事打造、小说撰写等场景的应用,该条规定明显过于严苛。

此外,我国也可以参考法案,采取监管沙盒的创新监管措施,在一定范围内对人工智能产品和服务进行测试。2021年3月,中国证监会在北京进行了金融科技的监管沙盒试点,其中不乏利用人工智能的金融科技技术。人工智能产品和服务的应用领域并不局限于金融领域,为保障消费者权益,减少人工智能投入市场后的风险,工信部、网信办等主管部门可以牵头进行人工智能监管沙盒的试点,推动人工智能健康有序发展。